Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Aaron Levie

administrerende direktør @box - slipp løs kraften i innholdet ditt med AI

En subtil grunn til at markedsstørrelsen for AI-agenter kommer til å bli større enn vi er klar over, er at det er mange brukstilfeller der det er verdifullt å kjøre flere agenter parallelt for å løse det samme problemet.

Dette var faktisk aldri mulig med de fleste kunnskapsarbeid før. Det ville bare ha vært uoverkommelig å kaste flere mennesker på det samme problemet. Men fordi vi dramatisk har senket kostnadene ved å distribuere etterretning, har du råd til å ha mer redundans og vurdere ting fra enda flere vinkler.

Vi ser allerede disse eksemplene på en rekke områder. Folk bruker AI-kodegjennomgangsagenter på de samme kodeendringene for å tilby subtile forskjeller i analysen. Det samme vil gjelde for å få sikkerhetsagenter til å gjennomgå kode, der det bare er mer verdi i ekstra dekning. I dype forskningsoppgaver er det ofte nyttig å ha flere spørsmål som kjører parallelt for å sammenligne ulike tilnærminger.

Og vi kan forvente at dette vil dukke opp på tvers av mange andre felt der flere forskjellige visninger gir inkrementell verdi til en arbeidsflyt, som juridisk arbeid, helsevesen, økonomisk analyse, vitenskapelig forskning, produktideer, oppretting av markedsføringsinnhold og mer.

Dette er grunnen til at det er umulig å estimere full TAM for mange av disse markedene. Hvis du trodde agenter bare tilnærmer oss hvordan vi jobber i dag 1:1, ville det være lett å gå glipp av alle måtene vi vil bruke agenter på i arbeidsflyter. Dette er grunnen til at disse markedene ikke har noe naturlig tak i fremtiden.

88,16K

AI-agenter er en reell transformasjon innen inntektsgenerering av programvare.

Tradisjonelt var programvare stort sett begrenset til ~$10-50 eller så per måned per sete for en bestemt programvare. Det er avvikende vertikal programvare, men den hadde generelt alltid omtrent dette taket.

AI-agenter på den annen side er i hovedsak ubegrenset fordi det ikke er noen reell øvre grense for hva noen ville gjort med en AI-agent i en arbeidsflyt.

Vi ser allerede dette i programvarekodingsagenter der noen betaler i tusener per måned. Og dette er helt rimelig: hvis en bruker er 2X-3X mer produktiv med AI-kodeagenter, vil ikke et selskap blunke ved å bruke 10 % på tilsvarende lønn på agenter.

Men dette begynner også å skje på tvers av generelle kunnskapsområder, som juridisk analyse, gjennomgang av medisinske rapporter, behandling av lånedokumenter og mer. Vi bør forvente denne dynamikken i alle kategorier av arbeid.

Nå, etter hvert som modellforbedringer skjer, vil like-for-like-prisene gå ned. Men så, ettersom AI-agenter kan utføre mer komplekse oppgaver, og du kjører flere og flere agenter parallelt i en arbeidsflyt, vil bedrifter bare distribuere flere av disse agentene. Ville tider fremover.

Gergely Orosz14. aug., 14:58

Vi har gått så raskt fra "ikke sikker på at jeg vil betale $20/måned for et annet AI-kodeverktøy når jeg allerede betaler $20/md for ett" til "abonnementet mitt på $200/måned fortsetter å gå tom for grenser - hjelp!!"

Utviklere som aktivt bruker LLM-er for jobb, trender til å betale enkelt $1,000+/måned snart ...

94,55K

Bortsett fra noen få kategorier, er de fleste rom fortsatt vidåpne innen AI. Dette vil ikke være sant for alltid fordi data og arbeidsflyt vil begynne å bygge seg opp, men det er absolutt midlertidig sant akkurat nå.

AI har utviklet seg så mye det siste året at modellene har løst massevis av problemene som de fleste startups måtte bygge rundt før. Og hvorfor du kan gjøre med AI-agenter i dag er omtrent 100 ganger kraftigere enn for 2 år siden.

Dette er også grunnen til at det er avgjørende å bygge arkitekturer med de riktige abstraksjonslagene for å dra nytte av disse oppdateringene.

Olivia Moore14. aug., 09:26

Noen ganger hører jeg potensielle gründere si at de er "for sent" til AI

Men fordi modellene forbedres så raskt, er du i mange kategorier / produkttyper fordelaktig ved å starte senere

Du trenger ikke bruke tid (og $) på å bygge infra/modeller som vil være API-tilgjengelig

67,08K

AI vil viske ut grensene mellom mange funksjoner over tid fordi du nå kan begynne å gjøre ting enten høyere eller lavere i stabelen, eller utvide til andre tilstøtende funksjoner. Et veldig åpenbart område er at PM-er nesten alltid skal dukke opp med funksjonelle prototyper.

Kaz Nejatian13. aug., 21:57

Vi legger til en kodingsseksjon i alle våre produktsjefsintervjuer på @Shopify.

Vi starter med APM-intervjuer. Vi forventer at kandidatene bygger en prototype av produktet de foreslo i caseintervjuet.

Det er ingen unnskyldning for statsledere som ikke bygger prototyper.

66,13K

Hos Box bruker vi mye tid på å teste Box AI med nye modeller på ustrukturerte data for å se hva de presterer godt på i reelle områder av kunnskapsarbeid.

Som vi har sett fra referansene, tilbyr GPT-5 et meningsfullt hopp i kapasitet i forhold til GPT-4.1 innen resonnement, matematikk, logikk, koding og andre arbeidsområder. Her er noen eksempler på hvor disse forbedringene spiller inn i den virkelige verden:

*GPT 5 kontekstualiserer informasjon bedre. Når du utfører datautvinning som det endelige USD-beløpet på en faktura uten valutaetiketter, men med adresse i London, svarer GPT 5 riktig og trenger en konverteringskurs fra USD til GBP. Til sammenligning så GPT 4.1 den endelige regningen og returnerte den, forutsatt valutaen (feil).

* GPT-5 gir bedre multimodal analyse. For et offentlig selskaps årlige innlevering blir GPT-5 bedt om å isolere en celle i en tabell fra et bilde som viser endringer i selskapets egenkapitalkomponenter. Toppen av tabellen presiserer at alle aksjebeløp er i tusenvis, og GPT-5 sier tydelig denne konverteringen, mens GPT-4.1 ikke gjør det, og blir forvirret gitt at tabellen sier aksjer og legenden sier aksjer.

* GPT-5 yter bedre med høye nivåer av prompt og datakompleksitet. Når GPT-5 gjorde datautvinning på en CV for alle jobbstartdatoer, stillingsnavn og arbeidsgivernavn, var GPT-5 i stand til å trekke ut alle data mens GPT-4.1 ser ut til å bli overveldet og ikke trakk ut de samme feltene gitt størrelsen på ledeteksten og kompleksiteten til dokumentet.

* GPT-5 er mye tydeligere og mer eksplisitt i svarene sine. I en outsourcingavtale med 6 forskjellige tjenester som eksplisitt er diskutert, vil GPT-5 returnere de første 5 og spørre om det var med vilje at den sjette ikke ble spurt om. Til sammenligning returnerte GPT-4.1 ganske enkelt de første 5 uten ytterligere forbehold, noe som kan føre til nedstrøms forvirring for brukeren.

* GPT-5 er bedre på datatolkning i komplekse felt. For et flowcytometridiagram, vanligvis brukt i immunologi, identifiserte GPT-5 korrekt en høy andel døde celler og ga plausible rotårsaker som kan føre til situasjonen, mens GPT-4.1 ga minimal begrunnelse, og trengte ytterligere bekreftelse for å ha noen gjetninger fra rådata.

* GPT-5 er bedre i stand til å identifisere inkonsekvenser i kode. Da de ble bedt om å identifisere problemer i en gitt python-kodefil, mens både GPT-5 og 4.1 kan identifisere reelle feil som fører til funksjonsfeil, var det bare GPT-5 som var i stand til å utlede mer subtile problemer, som å skrive ut feil variabel når det ikke ville gi mening i konteksten til programmet.

Disse forbedringene i matematikk, resonnement, logikk og kvaliteten på svarene i lengre kontekstvinduer er utrolig nyttige for sluttbrukere i det daglige arbeidet, men de vil dukke opp enda mer med lengre kjørende AI-agenter, spesielt når det ikke er noe menneske i løkken for å verifisere informasjonen på hvert trinn.

Det er fantastisk å se at disse forbedringene fortsetter å komme i den siste avlingen av AI-modeller, da dette vil føre til AI-agenter som kan brukes i trinnvis mer oppdragskritiske arbeidsområder.

77,96K

Det er tydelig at vi akkurat nå er på en bane med AI-modeller som fortsetter å forbedre kapasiteten på tvers av matematikk, resonnement, logikk, verktøykall og ulike domenespesifikke oppgaver som vil bli bedre etter hvert som flere treningsdata fortsetter å bli generert.

Selv om det vil være debatter om hvor mye disse fremskrittene vil vise seg som store endringer i de daglige brukstilfellene som en forbruker har, *vil* de ha stor innvirkning på tvers av mange kategorier av kunnskapsarbeid. De vil trinnvis låse opp nye brukstilfeller innen helsevesen, juridiske, finansielle tjenester, biovitenskap, etc., der modeller pålitelig kan utføre gradvis mer kritiske oppgaver.

På en nylig podcast med Alex Kantrowitz hadde Dario Amodei en fin måte å ramme inn dette på, som er at hvis du forbedret evnen til en AI-modell til å gå fra å ha en lavere grad i biokjemi til å ha en høyere grad i biokjemi, ville en liten prosentandel av forbrukerbefolkningen merke virkningen, men bedriftsbrukstilfellene for et selskap som Pfizer ville øke meningsfullt som et resultat av dette.

Vi bør begynne å forutse at dette nå er epoken vi er inne i med AI. Så, hvordan begynner dette å dukke opp i den virkelige verden? Det vil dukke opp gjennom AI-agenter som går etter brukte brukstilfeller. AI-agenter for koding, juridisk arbeid, medisinske skrivere, datautvinning, behandling av forsikringskrav, pennetesting og så videre.

Muligheten akkurat nå er å bygge AI-agenter for vertikaler og domener med en dyp forståelse av det området. Det er her virkningen av kontekstteknikk, en dyp forståelse av arbeidsflytene, tilkoblinger til bedriftsdata og spesialiserte brukergrensesnitt (som lar brukere distribuere, administrere og orkestrere disse agentene) vil begynne å bety mye.

Det vil også bety å bygge opp distribusjon som er i tråd med den aktuelle vertikalen eller domenet. Det vil sannsynligvis bety en form for fremoverdistribuert teknikk for ikke bare å hjelpe kundene med å implementere agentene, men også raskt lære hvilke arbeidsflyter agentene er optimalisert for og bringe det tilbake til kjerneplattformen.

Til syvende og sist vil disse markedene bli vunnet av aktørene som best kan bygge bro mellom dagens bedriftsprosesser (som ofte er rotete og ikke er designet for automatisering) til en verden der agenter er integrert i disse arbeidsflytene. Dette er epoken med AI vi nå er inne i.

77,83K

Vi er ikke i nærheten av det optimale punktet for stabilisering i AI-kapasitet, men ironisk nok er det mange kommersielle brukstilfeller for AI som bare blir frosset på grunn av hvor raskt teknologien utvikler seg. Dette er grunnen til at fremtidssikre arkitekturer betyr så mye.

Ethan Mollick11. aug., 18:39

Når og hvis AI-utviklingen platåer (og ingen indikasjoner på at det skjer ennå), kan det faktisk akselerere AI-integrasjon i livene våre, for da blir det lettere å finne ut hvilke produkter og tjenester som trengs for å utfylle AI. Akkurat nå endres funksjonene for raskt

3,94K

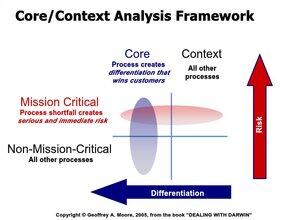

Kjerne vs. kontekst er et kritisk konsept å tenke gjennom når man finner ut hva folk vil gjenoppbygge seg selv med AI.

Bedrifter bringer inn "kjernefunksjoner" som skiller dem. Dette er hva kjerneproduktet eller tjenesten deres er, hvordan de selger til kunder, ting som driver kulturen deres, og så videre.

Omvendt outsourcer de "konteksten" som er bordinnsats for å få rett, men tilbyr bare ulemper ved å ta feil. En enkel tommelfingerregel å tenke gjennom er vil en kunde noen gang legge merke til om selskapet gjorde den funksjonen direkte selv eller ikke.

Bedriftsprogramvare er nesten alltid "kontekst". Dette er områder som deres CRM- eller HR-systemer, infrastruktur, datahåndtering og så videre. Disse er nødvendige for å drive en virksomhet i stor skala, men sjelden er du fordelaktig i å prøve å rulle din egen. Bare noen få unntak finnes, og det er nesten alltid fordi du trenger en løsning for å betjene "kjernen" din som ingen leverandør tilbyr (som om du trengte tilpasset programvare for en vertikalt integrert forsyningskjede).

Uansett hvordan et selskap starter, skiller de til slutt nesten alltid arbeid og verdi mellom kjerne vs. kontekst over tid. Det er den eneste måten de kan holde seg konkurransedyktige og til slutt allokere ressurser til de optimale områdene.

Så selv om et selskap *kunne* omskrive bedriftsprogramvaren sin med AI, ville de i utgangspunktet bare ikke gjort det. Versjonsoppdateringer, sikkerhet, regulatoriske funksjoner, feil, SLAer, nødvendige profesjonelle tjenester osv.

Som bucco påpeker, er den virkelige risikoen bedre versjoner av disse verktøyene som er AI-først. Det er det du bør passe på fra et disrupsjonssynspunkt.

BuccoCapital Bloke10. aug., 01:04

Jeg tror risikoen for at selskaper bygger sine egne registreringssystemer - ERP, ITSM, CRM etc - er utrolig lav

Bedrifter er ikke dumme. De har ingen kompetanse her, innsatsen er enormt høy, og uansett hvor enkelt det er, ville de fortsatt ha vedlikeholdt og optimalisert det, noe som til syvende og sist er en distraksjon fra deres faktiske virksomhet. Samme grunn til at AWS, Azure og GCP er så utrolige virksomheter

Jeg tror virkelig at menneskene som tror dette enten aldri har jobbet i en ekte virksomhet eller rett og slett lever i regneark uten forståelse av hvordan bedriftsprogramvare kjøpes og selges

Jeg tror imidlertid risikoen for at de eldre SaaS-leverandørene blir slått av AI-innfødte konkurrenter nedenfra er mye høyere

Figma spiste Adobes lunsj fordi samarbeid var hjemmehørende i skyen og Adobe ikke kunne tilpasse seg. Det er den typen risiko som bør være å holde disse eldre registreringssystemene oppe om natten, ikke folk som vibber en erstatning.

195,85K

Flott tråd. Uansett hva en AI-agent er i stand til å gjøre, kan den også lures til å gjøre. Du bør anta at hvis en agent har tilgang til data, at en bruker til slutt også kan få disse dataene. Agentsikkerhet, tilgangskontroller og deterministiske rekkverk vil være avgjørende.

mbg8. aug., 21:49

Vi kapret Microsofts Copilot Studio-agenter og fikk dem til å søle ut sin private kunnskap, avsløre verktøyene sine og la oss bruke dem til å dumpe fulle CRM-plater

Dette er autonome agenter. Ingen mennesker i løkken

#DEFCON #BHUSA @tamirishaysh

90,77K

Mye samtale om hvordan fremtiden for programvare ser ut i bedriften. Slik tror jeg det utspiller seg.

For deterministiske arbeidsflyter der kostnadene ved å gjøre noe galt er høye, vil bedrifter ha en tendens til å velge kjerneplattformer for sine vanligste, viktigste og repeterbare funksjoner i organisasjonen. Tenk lønn, ERP, CRM, ITSM, kundestøtte, ECM/dokumenthåndtering og så videre. Dette er områder hvor du vil ha noe gjort på samme måte, hver gang.

Hver av disse plattformene må være AI-først av design, noe som betyr at de vil ha brukergrensesnitt som blir innstilt for å samhandle med arbeidsflytene og dataene via AI, og være fullt designet for AI-agenter å operere i plattformene. Over tid kan vi forvente at bruken av disse systemene vil påvirke langt mer til AI-agenter enn til og med mennesker. Setemodellen forblir for brukerne, men forbruk blir modellen for agenter. Noen sittende vil komme seg til slutttilstanden, men andre vil ikke tilpasse seg raskt nok og dø av.

Det vil da være en ny avling av selskaper som kun er agenter som er spesialbygd for å automatisere spesifikke typer arbeid (og spesielt for ikke-deterministisk arbeid). Forretningsmodellene deres vil vippe enda mer forbruk. Tenk Claude Code eller Devins (sannsynligvis med et UI-lag for å administrere agentene), men for forskjellige jobbfunksjoner. Vi vil sannsynligvis se hundrevis eller tusenvis av disse dukke opp over tid. Pennetesting, koding, feilfinning, samsvarsgjennomganger, finansanalytikere og så videre. Dette er et stort område hvor startups vil gjøre det ganske bra fordi det har en tendens til å ikke være noen programvareetablerte i disse kategoriene.

Vi vil samhandle med disse ulike agentene fra en blanding av programvareplattformene de er knyttet til (som Box AI eller Agentforce), via APIer i andre systemer, og horisontale arbeidsflytsystemer som syr sammen agenter på tvers av plattformer (som ServiceNow, IBM Watsonx, Google Agentspace og så videre).

Og selvfølgelig vil brukere ofte konsumere disse agentene via horisontale chat-opplevelser (som ChatGPT, Claude, Perplexity, Grok, Copilot, etc.) via MCP eller andre typer direkte tilkoblinger. Brukere vil vanligvis jobbe i disse horisontale chat-systemene, og trekke inn agenter, data og arbeidsflyter fra de forskjellige Agentic-plattformene etter behov. Når det er relevant, vil de hoppe inn i kjerneplattformene for å fullføre arbeidsflyter, gjennomgå informasjon osv.

Det vil også være en lang hale av opplevelser der brukere kan generere mikroapper på farten når de trenger raske applikasjoner eller brukstilfeller automatisert, når det ikke er noen åpenbar programvare å gjøre det med. Dette kan skje direkte i de horisontale chat-systemene, et verktøy som Replit, Lovable eller i automatiseringsverktøy for arbeidsflyt, etc. Jeg forventer at dette er mer for superbrukerne der de trenger lim mellom flere systemer eller der det ennå ikke finnes programvare.

Nettet av det er at programvare bare blir viktigere over tid, selv om modalitetene der vi samhandler endres og utvides. I likhet med hvordan vi enkelt hopper mellom telefonene og stasjonære datamaskiner, selv om de lett kan konvergere, vil fremtiden tilby en blanding av måter å samhandle med programvare på.

127,41K

Topp

Rangering

Favoritter

Trendende onchain

Trendende på X

Nylig toppfinansiering

Mest lagt merke til